Intro

Mere end halvdelen af alle onlinesøgninger sker på mobile enheder. Alligevel kæmper mange hjemmesider med at dukke op i søgeresultaterne. Du har måske problemer med Googles indeks, når nye sider ikke bliver crawlet. Eller når robots.txt blokerer for de stier, du vil have Google til at se.

Din hjemmeside kan forsvinde fra søgninger, hvis der ikke er noget sitemap, eller hvis ingen indekstags er aktive. Problemerne starter, når indstillingerne er forældede, der mangler alt-tekst, eller links er ødelagte. I de næste afsnit lærer du, hvordan du hurtigt kan løse disse problemer.

Forstå det grundlæggende i indeksering

Du vil gerne have, at dine sider dukker op i søgeresultaterne. Men det handler ikke kun om at tilføje nyt indhold. En god opsætning lader søgerobotterne finde dit site hurtigt og undgå problemer.

Google Search Console siger, at dit websted skal fungere godt for både brugere og bots. Det gør det lettere for dem at finde det, de har brug for.

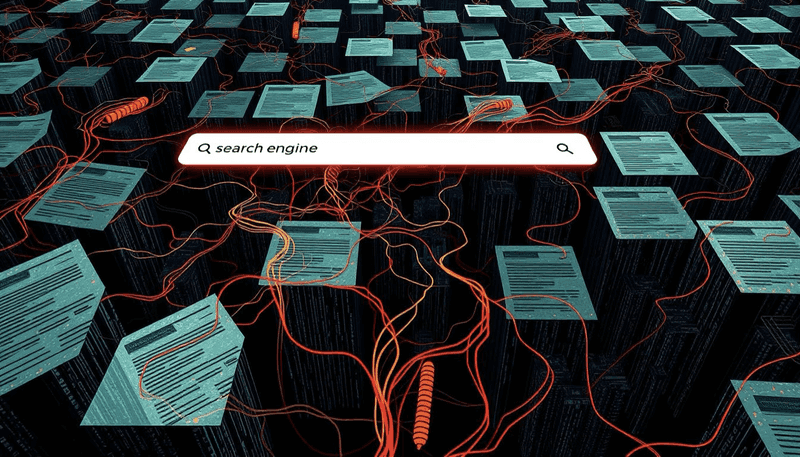

Søgemaskiner kigger på links, tjekker indholdet og gemmer det i store databaser. Det hjælper dine sider med at dukke op, når folk søger. Et velorganiseret site og nem navigation hjælper dig med at skille dig ud på nettet.

Søgemaskinernes rolle

Crawlere tjekker alle links for at se, om en side skal indekseres. Google ser på milliarder af sider hver dag. Så gør dit websted let at navigere på, og link godt.

Det gør det lettere for crawlere at finde det, de skal bruge. Det hjælper også dit site med at få bedre kontakt med andre.

Hvorfor indeksering er vigtig for dit website

Sider, der er indekseret, er mere tilbøjelige til at dukke op i søgninger. Hvis du løser indekseringsproblemer, bliver dit websted set mere. Hold din hjemmeside frisk, gør den mobilvenlig, og få gode backlinks.

Tegn på, at dit site ikke bliver indekseret

Når vigtige sider ikke får nogen organisk trafik, er det et rødt flag. Nul visninger i dine rapporter betyder, at søgemaskinerne ikke viser disse sider. Det sker normalt, fordi crawlere ikke kan få adgang til eller læse dit websted.

Alt-i-en-platformen til effektiv SEO

Bag enhver succesfuld virksomhed ligger en stærk SEO-kampagne. Men med utallige optimeringsværktøjer og -teknikker at vælge imellem kan det være svært at vide, hvor man skal starte. Nå, frygt ikke mere, for jeg har lige det, der kan hjælpe dig. Jeg præsenterer Ranktracker alt-i-en platformen til effektiv SEO

Vi har endelig åbnet for gratis registrering til Ranktracker!

Opret en gratis kontoEller logge ind med dine legitimationsoplysninger

Mange forhindringer kan blokere vejen. Manglende Sitemap betyder, at søgemaskinerne ikke kan finde dine URL'er. Dårlig webstedsstruktur skjuler vigtige sider og gør dem usynlige. Noindex Tag eller Header blokerer Googlebot, hvilket forhindrer dit indhold i at blive vist. Disse problemer forårsager ofte fejl i Googles søgekonsol.

- Tjek din indeksdækningsrapport for sider, der er mærket "ekskluderet" eller "opdaget, men ikke indekseret".

- Se efter uventede noindex-direktiver i din kode.

- Indsend et ordentligt sitemap for at hjælpe med at finde ud af det.

| Indikator | Forklaring |

| Lave eller ingen indtryk | Signaler om, at crawlere måske ikke når frem til dine sider |

| Nul klikfrekvens | Foreslår, at dit websted er usynligt for relevante forespørgsler |

| Fejl i Googles søgekonsol | Advarsler eller beskeder på højt niveau om fejl i crawling og indeksering |

Almindelige problemer med Google-indekset, du måske står over for

Føler du dig forvirret, når din hjemmeside ikke dukker op i søgeresultaterne? Fejlkonfigurerede 301-omdirigeringer eller mistænkelig kode kan skjule dine sider. Ved at se nærmere på mulige problemer kan du løse dem, før de skader din hjemmesides synlighed.

Crawling-fejl og server-svar

Ødelagte links, der forårsager 404-fejl, kan irritere crawlere. Google ser 410 sider som 404'ere. Omkring 40 % af indekseringsproblemerne er 5xx-fejl, som f.eks. servernedbrud eller timeouts.

Tjek serverlogs, undgå omdirigeringssløjfer, og hold serverindstillingerne stabile. Disse trin hjælper med at undgå disse problemer.

Forkerte kanoniske tags

Nogle sider peger måske på den forkerte kanoniske URL. Det får søgemaskinerne til at fokusere på det forkerte indhold. Det spilder crawl-budgettet og gør SERP'erne ufuldstændige.

Sørg for, at dine kanoniske referencer er korrekte. Det hjælper søgemaskinerne med at finde den rigtige primære version.

Duplikatindhold på tværs af sider

Kopieret tekst på flere URL'er forvirrer søgemaskinerne. Omkring 20 % af indekseringsproblemerne kommer fra dubletter uden kanoniske tags. Brug unikke beskrivelser, håndter sprogvariationer, og link til det rigtige domæne for at løse dette.

| Udgave | Mulig indvirkning | Anbefalet løsning |

| 404 eller 410 fejl | Reducerer crawlernes tillid | Reparer ødelagte links eller udfør gyldige omdirigeringer |

| Forkerte kanoniske tags | Forkerte sideplaceringer | Bekræft, at mål-URL'er er indstillet korrekt |

| Duplikeret indhold | Opdelte indekseringssignaler | Brug unik tekst og definer kanoniske referencer |

Robots.txt's rolle i indeksering

En lille fil i roden af dit domæne kan i høj grad påvirke søgemaskinernes visninger. Den fortæller crawlere som Googlebot, hvilke sider de skal se. En forkert opsætning kan give problemer, f.eks. at siderne ikke vises i søgeresultaterne. Læs mere om, hvordan du konfigurerer din robots.txt-fil korrekt for at undgå indekseringsproblemer.

Robots.txt guider crawlere, men blokerer ikke alt. Blokerede sider kan dukke op uden detaljer. Billeder og videoer kan blive påvirket, men links fra andre sider kan afsløre dem. Du har mere kontrol ved at tjekke HTTP-svar for at matche dine regler.

Sådan tjekker du din Robots.txt-fil

Find robots.txt på yourdomain.com/robots.txt. Google Search Console kan vise, om søgemaskinerne følger dine regler. CMS som Wix eller Blogger har indbyggede kontroller i stedet for at redigere filen.

Bedste praksis for håndtering af Robots.txt

Sørg for at målrette de rigtige crawlere med brugeragenter. Bloker ikke alt, medmindre du er nødt til det. Tilføj et sitemap-link for at vise, hvad der skal indekseres. Tjek filen ofte, hold den lille, og sørg for, at din server viser en 2xx-statuskode.

Løsning af sider blokeret af Robots.txt

Hvis din fil har User-agent: *Disallow: /, blokerer det hele webstedet for Googles bots. Hvis du fjerner denne linje eller retter stien, stopper du crawling- og indekseringsproblemer på sider, du gerne vil se. Du kan se en "Valid with warning"-meddelelse i Google Search Console, når URL'er indekseres, men er begrænsede. Det betyder, at du skal tjekke din fil og sørge for, at det kun er de rigtige dele, der er blokeret.

Alt-i-en-platformen til effektiv SEO

Bag enhver succesfuld virksomhed ligger en stærk SEO-kampagne. Men med utallige optimeringsværktøjer og -teknikker at vælge imellem kan det være svært at vide, hvor man skal starte. Nå, frygt ikke mere, for jeg har lige det, der kan hjælpe dig. Jeg præsenterer Ranktracker alt-i-en platformen til effektiv SEO

Vi har endelig åbnet for gratis registrering til Ranktracker!

Opret en gratis kontoEller logge ind med dine legitimationsoplysninger

Først skal du kigge efter linjer, der ved en fejl blokerer for vigtigt indhold. Plugins som Yoast SEO eller Rank Math på WordPress giver dig mulighed for at redigere robots.txt direkte. Shopify har en standardfil, der ikke kan ændres, så nogle brugere bruger en reverse proxy for at få mere kontrol.

Det kan tage et par dage, før ændringerne dukker op i søgeresultaterne, så hold øje med rapporten Index Coverage i Google Search Console.

Prøv disse trin for at rette blokerede sider:

- Fjern globale Disallow-direktiver, eller målret kun mod unødvendige mapper.

- Giv Google tid til at genindlæse eller indsende en manuel validering.

- Gentag kontrollen, indtil advarslen forsvinder fra din dækningsrapport.

Håndtering af andre indekseringsproblemer

Din hjemmeside dukker måske ikke op, hvis den mangler vigtige dele. Et XML-sitemap hjælper Google med at finde hver side. Det kan løse problemer som f.eks. at en hjemmeside ikke vises i Google. Manglende sitemaps er en stor årsag til lav synlighed.

Når du indsender dit sitemap via Google Search Console, bliver det fundet hurtigere. Det er meget nyttigt, hvis du ofte sender nyt indhold.

Forældreløse sider er et andet stort problem. Det er sider uden links til dem. Det gør det svært for søgemaskiner og besøgende at finde dem.

Det kan hjælpe at linke disse sider fra andre dele af din hjemmeside. Det kan forbedre din placering på vigtige søgeord. Det hjælper også med at undgå problemet med en URL, der er ukendt for Google.

Du kan også fjerne sider, der ikke tilfører værdi. Eller linke dem for at gøre din hjemmesidestruktur stærkere.

Indsendelse af sitemaps korrekt

Google Search Console kan fortælle dig, om dit sitemap er blevet accepteret. Sørg for at inkludere alle vigtige URL'er. Send ikke for mange sitemaps på én dag.

Rettelse af forældreløse sider

Et simpelt link kan gøre en side populær. Lav nemme stier fra din hjemmeside eller populære indlæg til disse skjulte sider.

| Indekserings-scenarie | Sandsynlig vending | Nøglefaktor |

| Ny hjemmeside | Op til 2 uger | Lavere krybeprioritet |

| Etableret blog | Ca. 24 timer | Hyppige opdateringer |

| Højt trafikeret websted | Inden for få timer | Højere crawl-budget |

Praktiske trin til gendannelse af indeksering

Start med at tilføje nyt indhold og tal direkte med Google. Mange brands får det bedre, når de løser indekseringsproblemer efter store ændringer. Det gør din side lettere at finde i søgeresultaterne.

De fleste mennesker bruger mobile enheder til at surfe. Så tjek dine sider hurtigt efter store ændringer. Google siger, at man skal vente mindst en uge, men store ændringer kan tage længere tid.

Opdatering og genudgivelse af gammelt indhold

Gør ældre indlæg friske med nye oplysninger eller synspunkter. Det fortæller crawlerne, at de skal komme tilbage tidligere. At ændre titler, tilføje tekst eller rette links kan gøre en side levende igen.

Brug Google Search Console til hurtige rettelser

Brug URL-inspektionsværktøjet til at bede Google om at tjekke dine opdateringer. Det er nyttigt ved store ændringer eller rebranding. Sørg for, at dit indhold er på over 300 ord, og undgå duplikatsider. Det holder dit website synligt i søgeresultaterne.

Løbende vedligeholdelse og overvågning

Hold øje med vigtige målinger for at øge din hjemmesides synlighed. Google foreslår, at du ofte tjekker Index Coverage Report. Det hjælper med at spotte fejl eller fald i crawlede sider.

At være opmærksom hjælper dig med at løse problemer, før de bliver værre. Hvis du hurtigt retter ødelagte links eller blokerede sider, holder du dit site synligt. Hvis du ignorerer disse problemer, kan det skade dit websteds omdømme.

Alt-i-en-platformen til effektiv SEO

Bag enhver succesfuld virksomhed ligger en stærk SEO-kampagne. Men med utallige optimeringsværktøjer og -teknikker at vælge imellem kan det være svært at vide, hvor man skal starte. Nå, frygt ikke mere, for jeg har lige det, der kan hjælpe dig. Jeg præsenterer Ranktracker alt-i-en platformen til effektiv SEO

Vi har endelig åbnet for gratis registrering til Ranktracker!

Opret en gratis kontoEller logge ind med dine legitimationsoplysninger

Regelmæssige tjek kan finde 503- eller 404-problemer. Brug af den rigtige HTTP-kode under nedetid hjælper din ranking. Ved at holde styr på disse problemer holder du dit site klar til nye chancer.

Konklusion

I en undersøgelse af 44 små og 18 større sider var det crawlfejl og bløde 404-sider, der skabte problemer. Forældreløse sider var svære for Googlebot at finde uden links. Websteder med over 100.000 sider spildte crawl-budget, og det gik mest ud over e-handelssider.

At rette robots.txt, sitemaps og canonical-tags hjælper med at holde dit website synligt. Det forhindrer problemer, der skader den organiske trafik. Det er vigtigt at tjekke Google Search Console for crawlfejl.

At fjerne sider med lav værdi hjælper Google med at fokusere på det, der er vigtigt. Omkring 70 % af webtrafikken kommer fra organiske søgninger. Hvis du holder dit websted opdateret og fri for tekniske problemer, forbedres placeringen.

Det er vigtigt at holde øje med din hjemmesides performance og handle hurtigt, når der opstår problemer.

OFTE STILLEDE SPØRGSMÅL

Hvad er problemer med Googles indeks, og hvordan kan de påvirke dit website?

Problemer med Googles indeks opstår, når dit indhold ikke er gemt rigtigt i Googles indeks. Det kan gøre dit website usynligt i Google, så du går glip af organisk trafik og får dårligere synlighed. Problemer som dårlige SEO-indstillinger, tekniske problemer eller indekseringsproblemer kan forårsage disse problemer.

Hvorfor vises dit website ikke i søgeresultaterne, og hvordan ved du, om det virkelig er indekseret?

Hvis dit website ikke er i Google, kan det skyldes indeksproblemer som manglende sitemaps eller blokerede sider. Tjek dit websteds status med Google Search Consoles rapporter "Indeksdækning" og "Sideindeksering". Disse værktøjer viser eventuelle problemer med crawling og indeksering, som påvirker din synlighed.

Hvordan fejlfinder du indekseringsanomalier ved hjælp af Google Search Console?

Start med at se på din indeksdækningsrapport for eventuelle udelukkede eller blokerede sider. Ret crawlfejl og ødelagte links, og indsend URL'er igen via URL-inspektionsværktøjet. Denne metode hjælper med at finde og løse indeksproblemer.

Hvilken rolle spiller robots.txt i søgemaskinernes indekseringsudfordringer?

Din robots.txt-fil styrer, hvad bots kan se på din hjemmeside. Hvis den blokerer vigtige sider, kan søgemaskinerne ikke crawle dem. Tjek og test jævnligt din robots.txt for at undgå fejl.

Hvordan kan du løse problemer med crawling og indeksering forårsaget af 404- eller 5xx-fejl?

Først skal du finde og rette de URL'er, der forårsager disse fejl. Det kan være ødelagte links eller forældede sider. Opdater links, løs serverproblemer, eller brug omdirigeringer. Send dem derefter ind igen, eller bed om nye søgninger for at indeksere dem korrekt.

Hvad er den bedste måde at håndtere forældreløse sider og ødelagte sitemaps på?

Forældreløse sider uden links kan blive overset. Tilføj links, eller fjern dem, hvis de ikke er nyttige. For ødelagte sitemaps skal du opdatere filen med gyldige URL'er og indsende den igen via Google Search Console.

Hvordan opretholder man en sund indeksering over tid?

Hold jævnligt øje med din hjemmeside. Tjek for duplikatindhold, forældede URL'er og fejl i Google Search Console. Opdater indhold, test robots.txt, og hold de kanoniske tags korrekte for at undgå indeksproblemer.